Offerte AMD MI300X. Questa non è un’APU come l’MI300A, ma una GPU di razza che è quasi traboccante di RAM. Dando ampia memoria con l’acceleratore un vantaggio rispetto ai concorrenti Nvidia e H100.

Innanzitutto, c’era solo l’AMD Instinct MI300: un’APU che combinava core Zen 4 con un chipset grafico basato su CDNA 3 e memoria HBM 3 condivisa. All’inizio di quest’anno, il chip è stato improvvisamente chiamato AMD Instinct MI300A, anche se l’aggiunta della “A” ha cambiato leggermente il concetto.

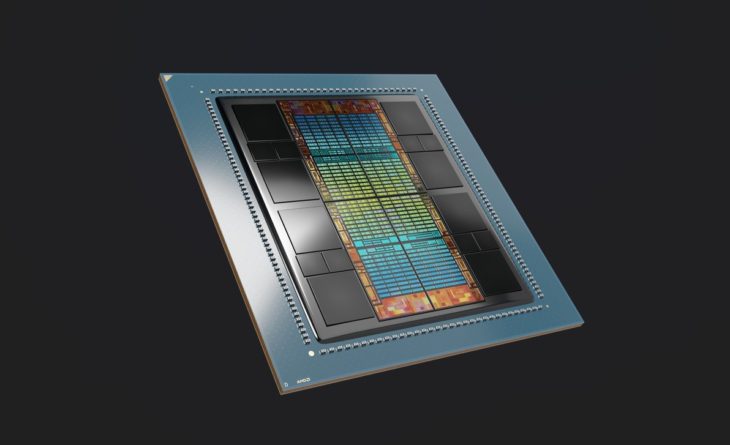

AMD Istinto MI300X

Alla premiere della tecnologia Datacenter e AI a San Francisco, negli Stati Uniti, ora sentiamo improvvisamente che l’Instinct MI300 è una famiglia e l’MI300A ha un fratello: l’AMD Instinct MI300X.

Con la versione X, AMD sfrutta il design flessibile del chip modulare dell’acceleratore estraendo 24 core Zen dal chip e inserendo altri 3 core GPU CDNA al loro posto. In altre parole, MI300X non è un’APU, ma un acceleratore relativamente classico che devi connettere a un processore sul server.

Modello completo in una diapositiva

MI300X viene fornito con 192 GB di memoria HBM 3 con larghezza di banda di 5,2 TB/s. “Il chip è ottimizzato per l’IA generativa”, afferma il CEO Lisa Su sul palco e durante la dimostrazione vediamo concretamente cosa significa. L’intero Falcon 40B si adatta all’enorme quantità di memoria integrata in esso tutto in una volta. Ad esempio, il chip può fornire inferenza anche con modelli di intelligenza artificiale molto completi.

MI300X ha 2,4 volte più memoria e 1,6 volte più larghezza di banda HBM rispetto a Nvidia H100. Sospettiamo se il chip sia anche più potente. MI300X è un guest teaser all’evento di San Francisco. Il vero lancio seguirà più tardi, quindi AMD non si sente obbligata a condividere subito specifiche come TDP o potenza di elaborazione nei Flop.

Queste specifiche sono anche oltre il punto su ciò che AMD sta posizionando nel mercato per Instinct MI300X. “Abbiamo un vantaggio in termini di costo totale di proprietà”, spiega Brad McCready, vicepresidente di Data Center e Rapid Processing presso AMD. “Certamente per inferenza, avremo un vantaggio in termini di inferenza per dollaro.”

Rispondi ai cambiamenti dei carichi di lavoro

McCready ammette che la divisione dell’Instinct MI300 in MI300A e MI300X non era stata pianificata fin dall’inizio. Ma è sempre stata un’opzione. Perché allora l’evoluzione da prodotto a famiglia di prodotti? “I carichi di lavoro IA si sono evoluti rapidamente e sono diventati più intensivi di calcolo. Ecco perché abbiamo deciso di realizzare l’MI300X, che, grazie al design modulare, non è stato così difficile.”

Per una somiglianza funzionale competitiva, guarda Nvidia H100 come controparte dell’MI300X e il superchip Nvidia Grace-Hopper come equivalente dell’MI300A.

piattaforma

Nel frattempo, nel palco principale, Su mostra un altro design della piattaforma con otto chipset MI300X in un layout server standard. Secondo lei, questo sarebbe facile e veloce da implementare nell’infrastruttura esistente. L’Instinct MI300A annunciato al CES è già stato provato dai clienti oggi. Instict MI300X consentirà ai partner di lanciare nel terzo trimestre di quest’anno. Entrambe le varianti dell’Instict MI300 dovrebbero entrare in produzione entro la fine dell’anno.